"Cogoloo" はクローズしました。開発記録のみ残しています。

この度、自動でWEBメディアの調査をしてくれるAI "Cogoloo" を開発してリリースしました。

この記事では、Cogolooのご紹介と、開発に至った経緯を記載しています。

目次

Cogolooとは

ユーザーが入力したキーワードに対して、WEB調査AI Cogolooが主要なWEBメディアを調査し、記載傾向の分析や、関連記事のクリッピングを自動でおこなってくれるツールです。

下記の写真の入力フォームに調査して欲しいキーワードを入力するだけで調査が開始されます。おおよそ調査は15分で完了します。

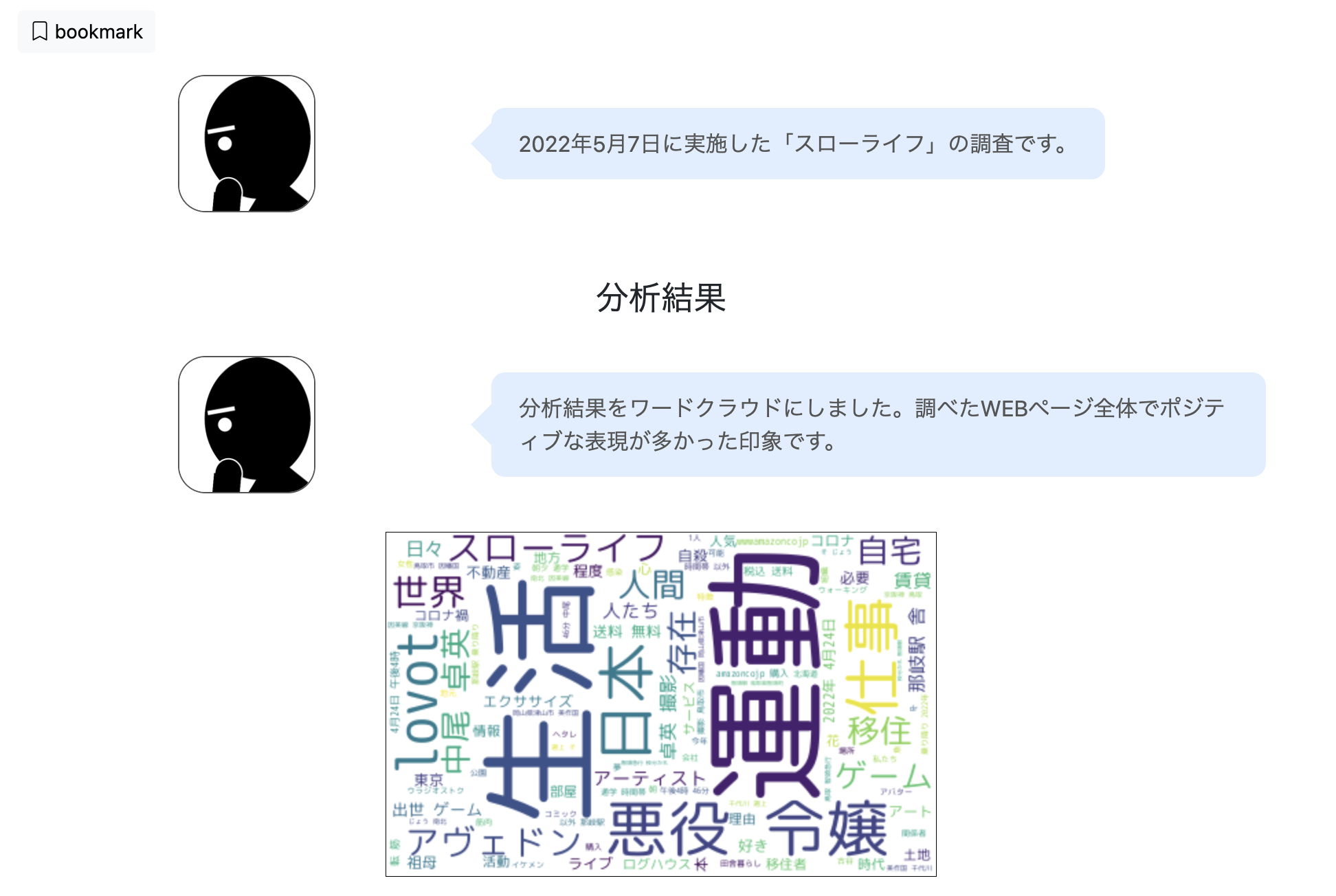

調査結果は以下のページのように表示されます。ワードクラウドや感情分析でキーワードの記載傾向のサマリーを知ることができます。

検索エンジンと違って、時間がかかりますため、即席な回答力は弱いですが、答えのないテーマを分析するための資料集め、およびWEB全体の大雑把なトレンドなどを知るのに便利なツールとなっております。

開発に至った経緯

WEBクリッピングを楽にしたい

さまざまな理由がありますが、一番のきっかけは私自身の普段の仕事上の課題です。

最近の仕事柄、WEB上のメディア記事をクリッピングして集めることが多い状況です。この作業はとても原始的で、主要なメディアサイトの新着記事や、メディアサイトの検索窓でサイト内検索を行い、記事をクリッピングしていくものです。

とても原始的で手作業な一方このような作業こそ自動化できるのではないかという気持ちがとてもありました。

WEB検索とは違うインターネットの調べ物体験を作りたい

インターネットで調べ物をするとなるとやっぱり、検索を使います。ところがYahoo!やGoogleの検索では、即席的な回答はすぐにできますが、回答のないものを調べるときにさまざまな視点のデータを得られないことが多いです。

特にニュースなどになると、似たようなニュース記事が新聞社各社のものが上にでるため、もっと多様な情報を触れたり、大まかでもいいので、ネットの記事全体のシェア範囲なども把握したいと思っておりました。

いわゆる「レディメイドのクロールと大衆の興味関心をベースにランキング付する検索エンジン」とは全く逆の、「オーダーメイドのクロール実施で、機械的かつ統計的な調査を行うエンジン(=AI)」というコンセプトで何かを作りたいという思いでこのツールを作ることにしました。

その他検索結果は水物なので、その時点で多くの言論がある記事のレポートキャプチャを残したいということもありました。そのため、Cogolooは一度調査したキーワードでも、1週間後には再調査をおこなって変化を計測できるようにしています。

新たなメディア記事の出会い体験を作りたい

手動クリッピングの頃から、トップページや検索にでてくる記事だけを眺める体験と違い、特定テーマだけの記事を探してみると、当初の調査したい目的とはややずれますが、新たな発見・興味関心がある記事が出てくることがあります。

この体験があるしゅこの仕事の楽しさでもありますが、それを1ページで一度にみれたり、調査記録として保存できるともっと楽しくなるのではないかと思いました。

ここは、実際に作ってみた時も成功で、機械的な抽出ゆえに、どう考えても当初の想定とは違う記事などがでたりしますが、そのなかに、「これなんだろう!おもしろそう」という体験が作れて良かったと思っています。

ちなみに、もとより、著作権法上の引用要件や機械学習関連で許可されている利用、利用規約やrobots.txtの遵守を行い、法令厳守・メディアサイト様の営業妨害・権利侵害をしないという注意のもと開発を行なっておりますが、こうした新たな体験で、クリッピングさせていただけるメディアサイト様のあらたなユーザー創出に貢献できれば、いわゆる「三方良し」としてみんな喜ぶ結果になるのではないかなと期待しております。

今後考えていること

今後の話というより、「Cogoloo」の由来ですが、ネット上のAI探偵のようなツールを作りたいということと、日本で有名な探偵といえば「明智小五郎」と「毛利小五郎」ということで語呂をとってこの名前にしました。目指している方向も調査を自動化するツールになります。

もっとも現状「AI」としては、現状は狭い意味で機械学習・推論といった狭義のAIをおこなっているのは感情分析だけです。

今後、たまった調査データを通じて、調査キーワードごとの関連性、調査結果の関連記事の連携をうまく学習させてサジェストするAPIが作成できればより深い調査レポートを提供できるのではないかと思っています。このようにして狭い意味でのAIの活用も増やせたらと思っています。

また、感情分析も「つらい・たのしい」といった形容詞のニュアンスから解析していますが、若干判定にあやしさがありますのでここもチューニングが必要と思っています。

ちなみに、現在調査対象にしているWEBサイトは私のニーズ優先で、ビジネス系メディア・アカデミック系サイトが多めです。そのため、調査対象メディアはバランスもって、増やしたり減らしたり、随時調整したいと思っています。また、対象を増やすと調査時間が増えるので、状況によっては調査対象を絞り込んだり、現状のクローラーのアルゴリズムやアーキテクトを調整しないといけないと思っています。

その他、現在プライバシーポリシーだけでなく、Cookie利用のモーダルを出したりしています。このツールに限らず、本「みやうラボ」でも実験したいと思っていますが、昨今のプライバシー情勢にあわせて、「真面目だけど違和感のない」Cookie利用に関するUIUX開発もやってみたいと思っております。

また、もともとは私の公私双方の調査活動をより拡充させたいという目的でしたので、今後Cogolooを通じて調査した内容の分析レポートもこのサイトの記事に追加できればと思っています。

終わりに

最後まで読んでいただきありがとうございました。

かなりニッチなニーズを解決することに特化したツールですが、もしもご興味がありましたら是非使ってみてください。